Así se ve afectada la ciencia cuando la tecnología es controlada por grandes corporaciones.

La Revolución de la Inteligencia Artificial: Un Desafío entre la Accesibilidad y la Regulación

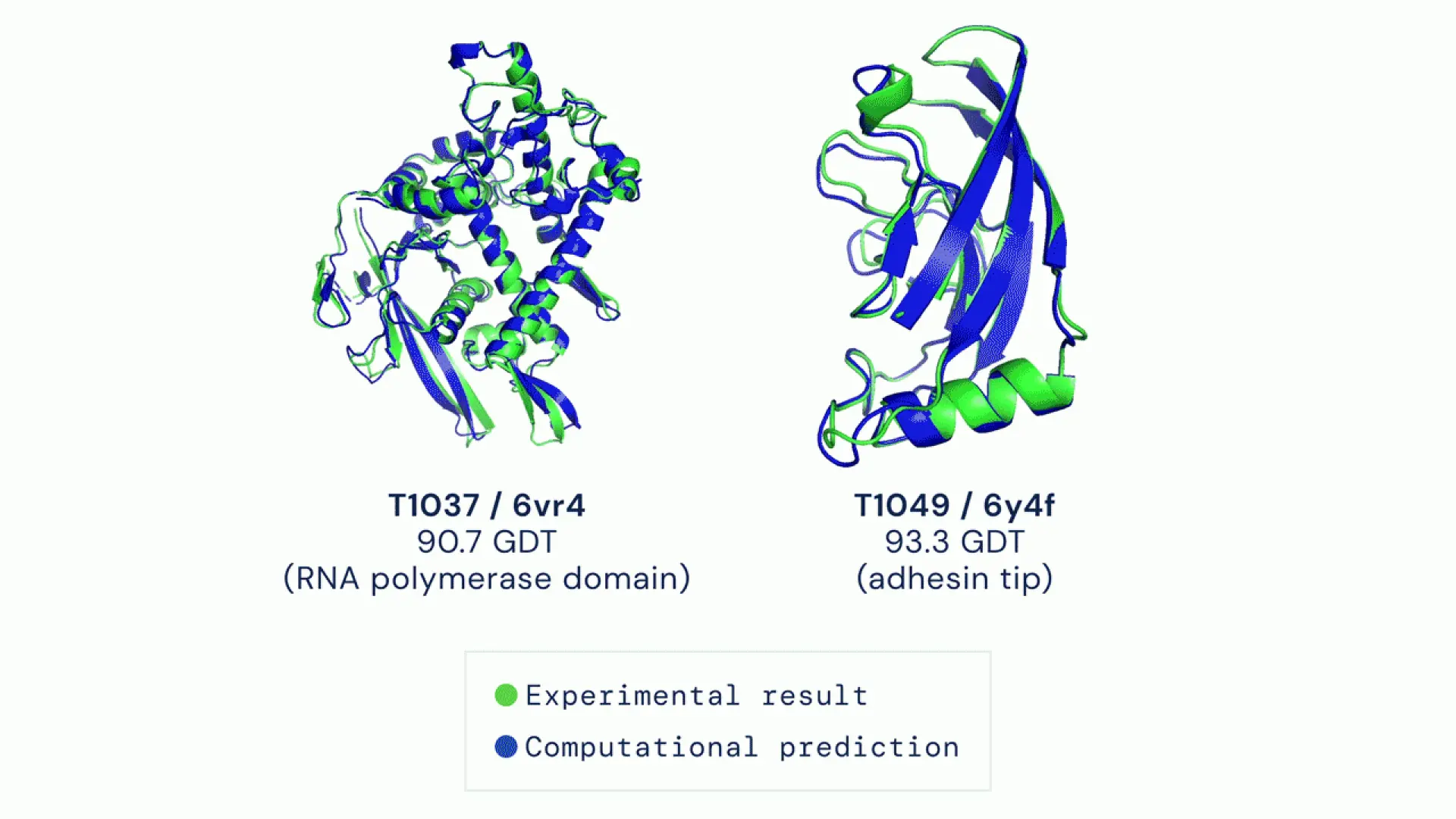

La Inteligencia Artificial (IA) está transformando el panorama científico y económico de manera acelerada. Un claro ejemplo de esta transformación es Chat GPT, que se ha convertido en la tecnología más rápida en su adopción en la historia. Recientemente, los premios Nobel de Física y Química han reconocido avances significativos en redes neuronales y su aplicación en la **predicción de estructuras proteínicas**, subrayando el impacto de la IA. Sin embargo, la aceleración de estos avances también ha generado preocupación sobre los potenciales riesgos y la necesidad de regulación.

La Dualidad de la Accesibilidad a Modelos de IA

La accesibilidad a los Modelos Fundacionales se manifiesta en diferentes formas. Estos modelos no solo incluyen los datos de entrenamiento sino también sus parámetros:

- Modelos completamente abiertos: como EleutherAI.

- Modelos con pesos abiertos: como Llama de Meta.

- Modelos abiertos con restricciones: como Bloom de Hugging Face.

- Modelos cerrados: accesibles a través de servidores, como OpenAI.

Estos distintos niveles de accesibilidad provocan un debate sobre vulnerabilidades y el uso adecuado de los modelos, compitiendo entre los beneficios de la colaboración científica y los riesgos de los ataques maliciosos.

El Peligro de la Regulación Excessiva

Investigadores en un reciente artículo en ‘Science’ advierten que el miedo a posibles riesgos podría provocar una regulación excesiva de los modelos abiertos. Esto puede frenar el desarrollo científico y favorecer a las grandes corporaciones que controlan modelos cerrados, que son más fáciles de supervisar pero difíciles de verificar.

Un Ejemplo Paradigmático: AlphaFold

El caso de AlphaFold, un sistema pionero en la predicción de estructuras de proteínas, ilustra estos dilemas. Mientras que AlphaFold 2 fue liberado como código abierto y ha permitido a la comunidad científica avanzar, su sucesor, AlphaFold 3, se mantiene cerrado, accesible solo mediante condiciones restrictivas. Esta decisión de DeepMind de Google ha generado un malestar significativo dentro de la comunidad investigadora, en contraste con los ideales del galardonado David Baker, quien promueve la investigación abierta.

Preocupaciones en la Publicación Científica

La publicación de resultados de AlphaFold 3 en ‘Nature’ sin la posibilidad de verificación por parte de revisores ha desatado críticas, desafiando principios fundamentales de la investigación. Un grupo de más de 1,000 científicos expresó su frustración en una carta abierta, señalando que tales decisiones son perjudiciales para el progreso científico.

Reflexiones Finales

A medida que la revolución de la inteligencia artificial avanza, es crucial equilibrar los beneficios del acceso abierto con las legítimas preocupaciones por la seguridad. Una regulación inadecuada podría limitar el desarrollo de tecnologías que son esenciales para la investigación y la independencia tecnológica, favoreciendo en su lugar modelos controlados por grandes corporaciones. Esta situación representa una serie de retos en la búsqueda de soluciones que beneficien a la comunidad científica en su conjunto.

Alfonso Valencia, Profesor ICREA y Director de Ciencias de la Vida en el Centro Nacional de Supercomputación de Barcelona

Este artículo ha sido proporcionado por el Science Media Centre España

– Ir al suplemento Tercer Milenio

Suscríbete y recibe cada semana en tu correo la newsletter de ciencia