Aumento del 100% en vLLM y del 30% en TensorRT-LLM con H100

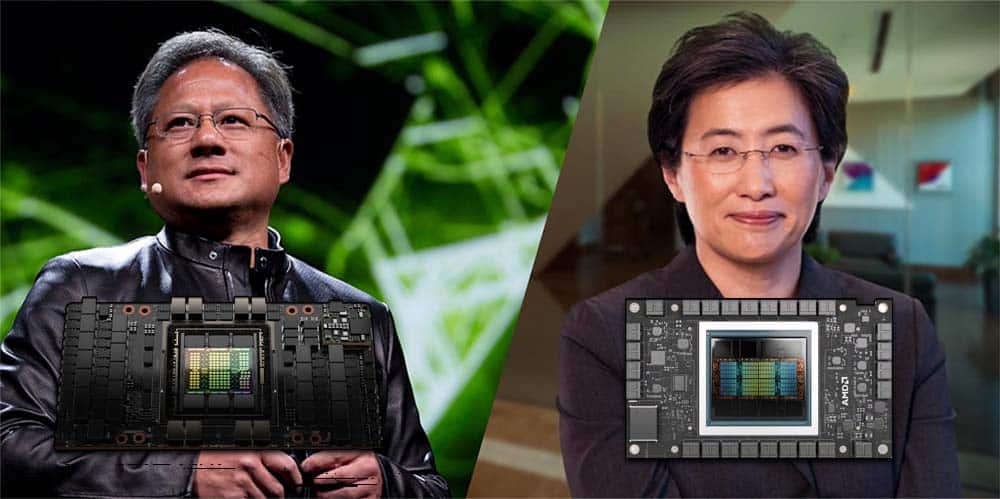

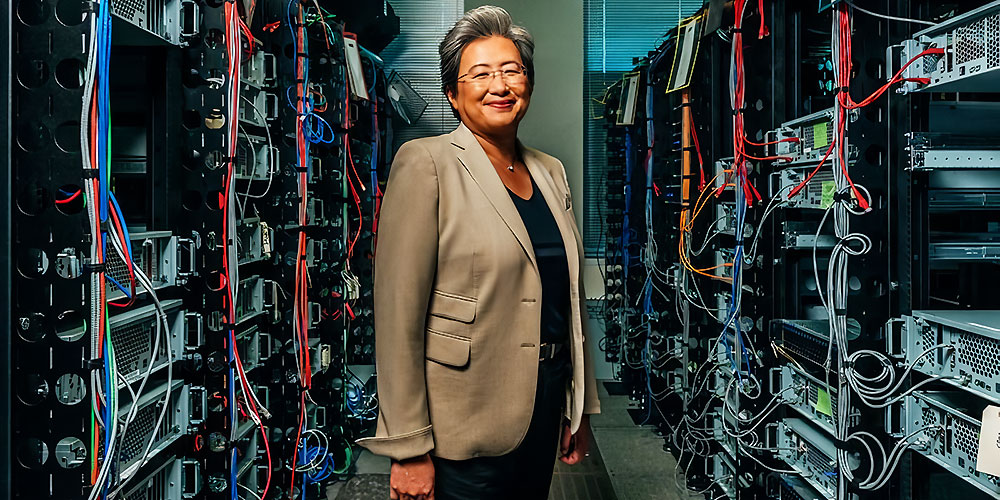

Por lo general, el enfoque principal en el lanzamiento de las GPU se encuentra en el gaming, con las NVIDIA RTX, AMD RX o las Intel Arc como opciones más populares. No obstante, las compañías dedicadas al desarrollo de inteligencia artificial (IA) están cada vez más interesadas en las GPU para IA de NVIDIA y AMD. Para este tipo de empresas, el rendimiento y el precio son factores clave a la hora de elegir una GPU. La MI300X de AMD con vLLM supera a la H100 de NVIDIA utilizando TensorRT-LLM en pruebas de software optimizado para IA.

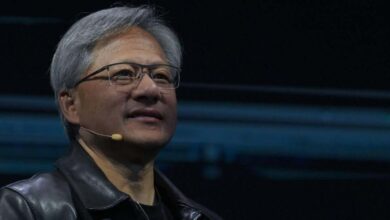

ChatGPT, lanzado en noviembre de 2022, es un ejemplo del creciente interés en la IA. En poco tiempo, las compañías han cambiado su enfoque de otros campos hacia la inteligencia artificial, convirtiéndola en uno de los mercados más importantes del mundo tecnológico. NVIDIA ha experimentado un aumento en sus ingresos gracias a que sus GPU para IA son las más rápidas del mercado.

AMD responde con su GPU MI300X con vLLM: un 30% más rápida que la H100 de NVIDIA con TensorRT-LLM

Existen oportunidades de mercado significativas para aquellas compañías que ofrezcan el mejor rendimiento en IA, especialmente en el ámbito de los servidores y centros de datos, así como en el desarrollo de modelos propios de IA. Hace poco, NVIDIA mostró cómo su H100 supera en rendimiento a la MI300X de AMD en un factor de dos. La compañía también acusó a AMD de haber hecho trampas en las pruebas para obtener resultados más favorables.

AMD, por otro lado, ha contraatacado al realizar pruebas utilizando software optimizado para IA. En estas pruebas, la MI300X alcanza el doble de rendimiento que la NVIDIA H100 HGX en vLLM al utilizar el modelo Llama 2 70B (desarrollado por Meta). Al emplear TensorRT-LLM en NVIDIA y vLLM en AMD, la GPU de AMD vuelve a ganar con un 30% de ventaja en rendimiento. Además, la latencia, medida en segundos, es ligeramente más baja en el caso de AMD.

AMD afirma que NVIDIA realizó pruebas de rendimiento injustas en IA

AMD alega que los resultados publicados por NVIDIA no son justos debido a diferentes factores. Se usó TensorRT-LLM en las H100 en lugar de vLLM en las MI300X de AMD, lo que le dio a NVIDIA una ventaja significativa. Además, AMD sostiene que las pruebas de NVIDIA no eran equiparables, ya que usaron FP16 para las GPU Instinct MI300X y FP8 en las H100.

AMD acusa a NVIDIA de manipular los datos de latencia relativa publicados por ellos y busca realizar una comparativa más justa con su rival. Incluso utilizando TensorRT-LLM en las GPU de NVIDIA, AMD sigue siendo superior en rendimiento. Aunque es probable que ambas compañías sigan compitiendo para demostrar quién es el líder en el campo de la IA, NVIDIA planea lanzar sus GPU H200 en 2024, con arquitectura Blackwell, las cuales prometen ser aún más rápidas.