Exinvestigadores del MIT proponen una solución inusual

La startup Cleanlab busca mejorar la confiabilidad de los chatbots

Los chatbots han sido el motor principal en el rápido crecimiento de la inteligencia artificial en los últimos años. Con opciones como ChatGPT, Copilot, Claude Chat y Perplexity, estas herramientas han capturado la atención del público. A pesar de su popularidad, es fundamental no tomar sus respuestas como absolutamente verdaderas.

Un ejemplo de ello es el abogado que utilizó a ChatGPT para tratar de ganar un caso en la corte, solo para descubrir que los documentos presentados contenían decisiones judiciales y citas falsas. Como podemos apreciar, los chatbots tienen mucho potencial, pero su fiabilidad a menudo no es garantizada.

Abordando el problema de la fiabilidad en chatbots

Un estudio reciente realizado por una empresa en crecimiento fundada por exempleados de Google indica que los chatbots tienen una tasa de alucinaciones de, por lo menos, el 3%. Si bien esto puede no ser preocupante para la mayoría de los usuarios en actividades recreativas, sí puede representar un problema en entornos profesionales.

Las herramientas basadas en grandes modelos de lenguaje (LLM) han empezado a ser implementadas en entornos empresariales, como por ejemplo Copilot en Office 365. Si los empleados reciben información incorrecta a través de estas herramientas, esto puede causar daños y complicaciones significativos a la empresa.

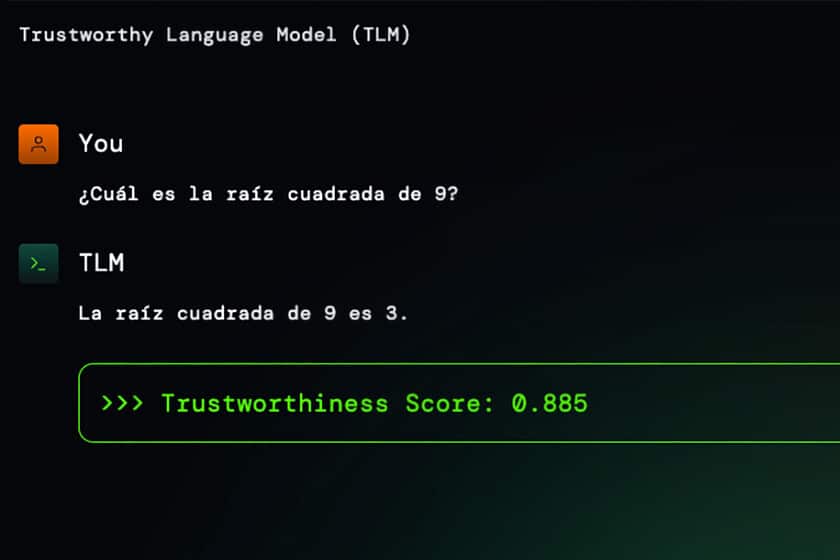

Por ello, Cleanlab, una startup creada por exinvestigadores del MIT, ha desarrollado una iniciativa llamada Trustworthy Language Model (TLM) para mejorar la fiabilidad de los chatbots. La idea es que TLM actúe como una «capa de confianza» que ayudará a los usuarios a saber qué tan fiable es la respuesta que acaban de recibir a partir de un sistema de calificación.

Esta herramienta está diseñada para funcionar en conjunto con modelos como GPT-3.5, GPT-4 y modelos personalizados de empresas. TLM envía nuestra pregunta a varios modelos y luego analiza sus respuestas. La respuesta se devuelve con un puntaje que va desde 0 hasta 1. Por ejemplo, al preguntar la raíz cuadrada de nueve, se recibe una respuesta correcta (3) con un puntaje de 0.885.

Cleanlab menciona que ChatGPT en su versión gratuita puede cometer errores incluso en preguntas simples. Un ejemplo es preguntar cuántas veces aparece la letra «N» en la palabra «enter»; el chatbot de OpenAI responde erróneamente que la letra aparece dos veces.

La startup ve un amplio espectro de aplicaciones para su tecnología, incluyendo la mejora de la fiabilidad en chatbots de atención al cliente. El chatbot operaría de manera automática, pero si la calificación de confiabilidad de una respuesta es baja, se puede solicitar la intervención de un agente humano.

Si estás interesado en probar la inteligencia artificial de TLM, puedes hacerlo a través de su sitio web. La herramienta también está disponible mediante una API. TLM ofrece versiones gratuitas de código abierto y versiones de pago con características adicionales.

Imágenes | Cleanlab | Captura de pantalla

En Xataka | El ganador más inesperado de la primera gran batalla por la IA es también al que dábamos por muerto: Meta