¿Por qué necesitamos una NPU si la IA puede funcionar en una CPU o GPU?

Introducción

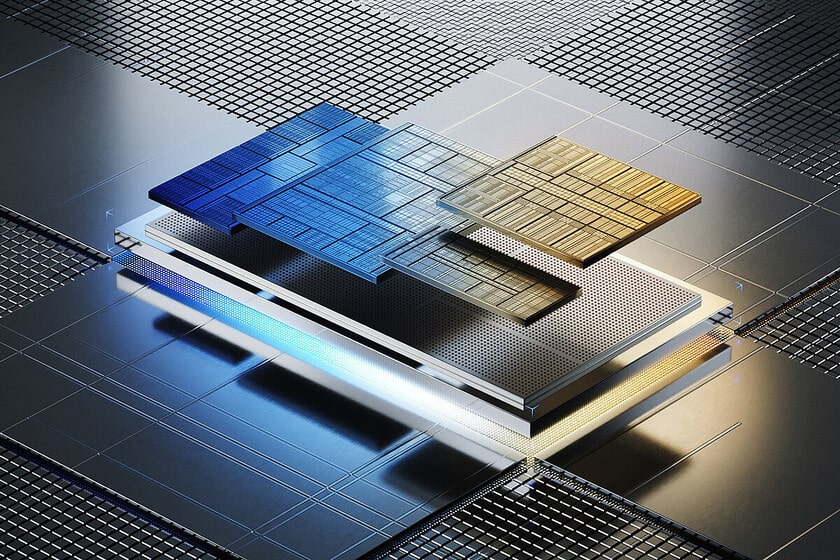

Las unidades de procesamiento neuronal (NPU) han irrumpido en el panorama tecnológico y han llegado para quedarse, especialmente en el ámbito de la inteligencia artificial (IA). Las NPU se suman a las arquitecturas heterogéneas, que combinan la CPU, la GPU y la NPU para garantizar el mejor rendimiento y la eficiencia energética. Empresas como Qualcomm, Intel, AMD, Apple, Samsung y Huawei ya están implementando chips con capacidad de cómputo heterogéneo y funciones específicas de procesamiento de IA.

¿Qué es la computación heterogénea y por qué es importante?

La computación heterogénea busca maximizar el rendimiento y la eficiencia energética distribuyendo la ejecución de los procesos entre tres tipos diferentes de unidades de procesamiento: la CPU, que tiene un propósito general; la GPU, encargada de gestionar los procesos relacionados con los gráficos; y la NPU, especializada en el manejo de procesos de IA. Es importante destacar que los procesos de IA pueden ejecutarse en cualquiera de estas unidades, pero la elección tendrá distintas consecuencias en términos de rendimiento y consumo de energía.

La GPU, la CPU y la NPU: ¿cuál es su papel en el procesamiento de IA?

La GPU es la unidad óptima para la paralelización masiva, una estrategia muy eficaz para abordar la generación de gráficos. La IA también se beneficia de este enfoque, especialmente si la GPU tiene unidades específicas para realizar operaciones matriciales altamente paralelizables. En la práctica, la GPU proporciona el rendimiento más alto para el procesamiento de IA, pero es la menos eficiente desde el punto de vista energético.

Por otro lado, la CPU también puede ejecutar procesos de IA, pero su arquitectura de propósito general y sin paralelización masiva hace que su rendimiento sea inferior al de la GPU en los algoritmos de IA. Sin embargo, es probable que consuma menos energía que la GPU al procesar IA. Por último, la NPU está diseñada específicamente para abordar procesos de IA de la manera más eficiente posible en términos de energía, aunque su rendimiento en procesos demandantes será menor que el de la CPU y, sobre todo, el de la GPU.

El futuro: convivencia de CPU, GPU y NPU

Aunque Intel y AMD han tardado más que otros fabricantes de SoC y APU en incorporar NPUs en sus productos, ya cuentan con chips que incluyen una NPU. En el futuro, ampliarán esta estrategia a otras líneas de productos. Por ejemplo, los procesadores Intel Core Ultra con microarquitectura Meteor Lake integran una NPU, mientras que los Ryzen 7040 y 8040 de AMD cuentan con una NPU con arquitectura XDNA, optimizada para procesar señales e IA.

Esta estrategia moldea el presente y el futuro de la computación de consumo y profesional. Las CPU, GPU y NPU están destinadas a coexistir y colaborar, lo que, sin duda, beneficia a los usuarios.